大数据文摘出品

最近,“元宇宙”的概念火了。

扎克伯格带着VR设备在虚拟办公室接受采访的视频在各大平台传播,人们似乎在期待一个新的时代的到来,就连相关的股票都应声上涨。

那么,我们离《头号玩家》中“绿洲”那样的元宇宙还有多远呢?

事实上,罗马不是一下子建成的。扎克伯格给“元宇宙”的计划时间是五年,技术也需要一步一步实现,这其中包括很多正在快速发展的技术,比如全自由交互。

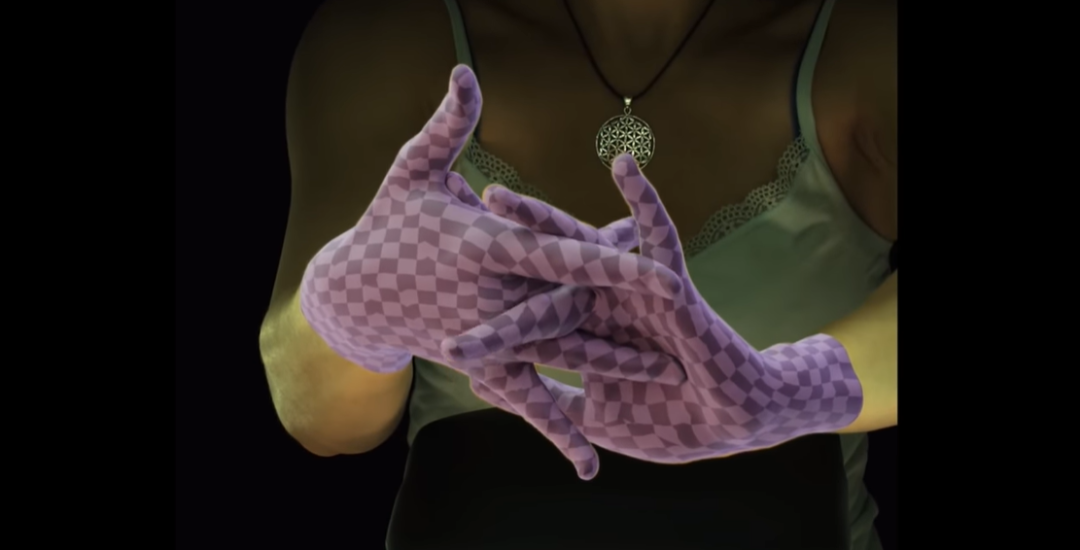

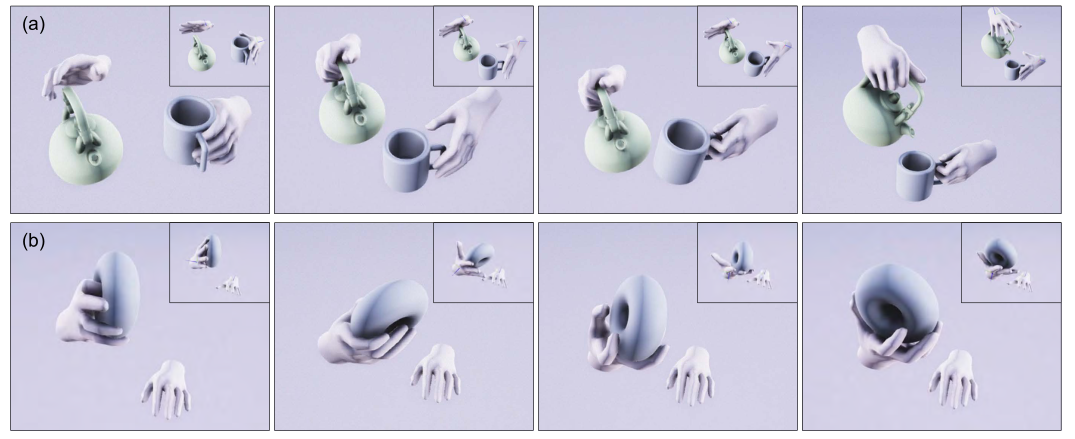

打个比方,如果我们要用我们的双手和虚拟世界交互,那么我们就需要对整个手部进行建模,比如这样:

是不是觉得不过如此?确实,很早之前,我们通过佩戴指环就可以大体实现这样的功能,但是,上面这张图中所展现的效果,并未借助任何手指传感器,仅仅是通过AI算法对摄像头中的手指进行建模就能得到如此精细的手部动作。

还觉得不过瘾的话,看看这个对搓手动作的还原,简直丝毫不差!

这项研究由来自爱丁堡大学的He Zhang和Facebook Reality Labs的几位合作者共同完成,对,就是那个致力于更精确的VR技术的Facebook Reality Labs!

论文链接:

无需手指传感器,还原最真实的手指运动

与其他类似研究相比,这项研究几乎拥有目前效果最好的手指动作建模。

这时候你可能觉得,这个AI还原的算法是不是通过在手指上接上传感器,然后获得大量的数据学习得来的?我们不妨看看论文附带的演示视频:

注意看右上角的Input,手指上没有任何传感器。

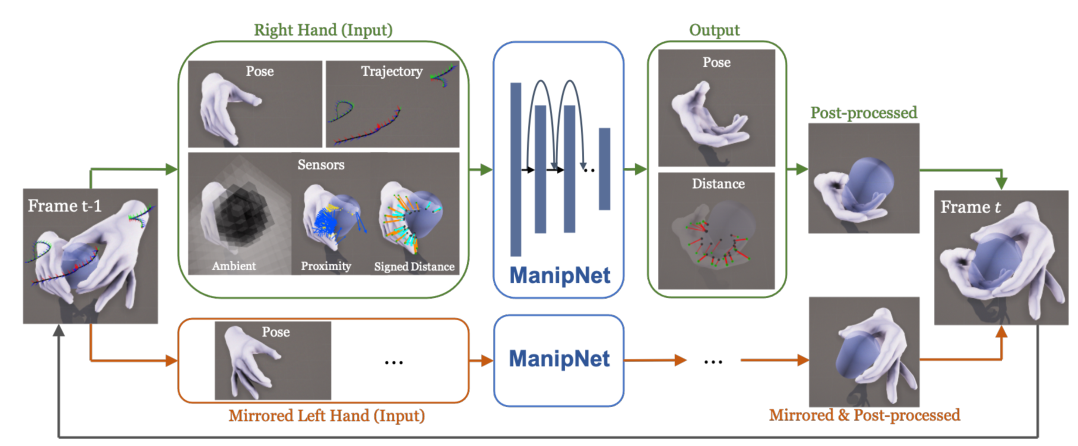

这一切都是依靠团队提出的ManipNet深度神经网络算法。ManipNet利用手-物体对象的空间之间的关系特征,直接从数据中学习手部的自然动作。

论文中,作者表示,该空间表征算法结合了作为体素占比(三维空间分割上的最小单位)的整体物体形状和作为最近距离样本的物体局部的几何细节。这种算法使得深度神经网络可以通过从手腕和物体的输入轨迹中模拟手指运动。

具体来说,ManipNet提供了过去、现在、未来三个节点的手指运动轨迹,以及从这些轨迹中提取的空间表征,然后深度神经网络会根据这些已有的数据生成一个自回归模型,预测从过去、现在到未来这几个节点之间缺少的其他手指姿态。

如上图所示,ManipNet是从控制信号和物体几何特征中预测操纵对象的手指姿态((a)右手握住茶壶,左手握住杯子(b)右手转动手中的圆环),其中控制信号是手腕和物体的6D轨迹,并且该深度神经网络只需要一个最小的和明确的输入表示,以便实现更好的泛化。

此外,ManipNet只处理一个手-物体的“输入”,然后通过镜像运算两次,为双手生成预测图像。

FRL为“元宇宙”提供更好的VR技术,相关技术国内也在发展

Facebook Reality Labs可以说是扎克伯格实现“元宇宙”梦想的重要技术动力来源。

在官网介绍中,Facebook Reality Labs表示,这里汇集了世界级的研究人员、开发人员和工程师团队,在虚拟现实和增强现实中建立未来的连接。

就像ManipNet这样的研究,正在不断的为“元宇宙”中现实与虚拟的交互添砖加瓦。

ManipNet的团队研究人员也表示,手指交互在游戏和AR/VR实时交互应用中有很大的潜力。“随着AR/VR硬件在消费者市场的崛起,将我们的系统与其内置对象跟踪相结合可以为新的互动内容打开了许多创造性的机会。”

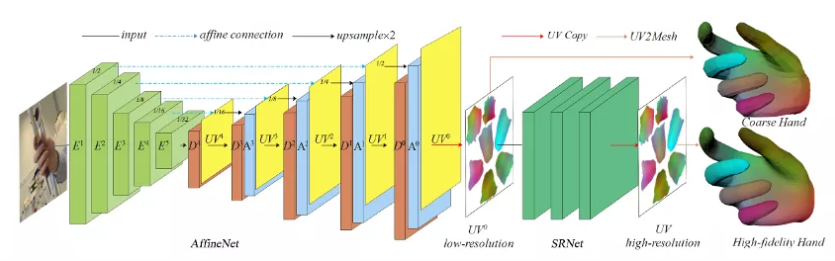

事实上,国内的一些公司也在研究相关技术,比如爱奇艺被计算机视觉领域国际顶会 ICCV 2021收录的一篇题为“I2UV-HandNet: Image-to-UV Prediction Network for Accurate and High-fidelity 3D Hand Mesh Modeling”,介绍的也是通过“看”单目RGB人手图片,就能实现高精度的人手三维重建。

爱奇艺这篇论文中提出的I2UV-HandNet,将UV映射表征引入到三维手势和形状估计中,其设计的UV重建模块AffineNet能够从单目图像中预测手部网络(hand mesh),从而完成由粗到精的人手3D模型重建。

这一设计意味着对于三维重建中所需的空间中的景深信息,不用再通过昂贵的硬件完成侦测,在普通RGB摄像头拍摄的图片中就可以完成景深信息获取。

I2UV-HandNet另一个组成部分是SRNet网络,其作用是对已有人手三维模型进行更高精度的重建。SRNet网络以研究团队独创的“将点的超分转化为图像超分的思想”为原则,实现在不增加过多计算量的情况下,进行上万点云的超分重建。

同样,爱奇艺团队也认为,手部、人体重建却是用自然的肢体语言实现人机交互的关键技术,相比一些可穿戴设备,更能带来体验和沉浸度。例如手柄无法模拟手指每一个关节的活动,手部重建则能实现更加精细的操控。这意味着这项技术可以应用在游戏、数字化工厂、虚拟场景培训等更多场景。

相关报道:

https://www.youtube.com/watch?v=_9Bli4zCzZY

https://mp.weixin.qq.com/s/iyQRA6t4Ngcb7hRBdJ-ftw

https://research.fb.com/wp-content/uploads/2021/06/ManipNet-Neural-Manipulation-Synthesis-with-a-Hand-Object-Spatial-Representation.pdf

http://www.diankeji.com/vr/47299.html

文章评论